代号Spark安装与配置指南:全面解析及操作步骤详解

在当今大数据的时代背景下,Apache Spark作为一种强大的大数据处理工具,受到了广泛关注与应用。其高效的内存管理、灵活的编程模型和强大的计算性能,使得Spark在数据分析、机器学习等领域表现出色。本文将详细介绍Spark的安装与配置过程,帮助读者快速上手,并为其在实际应用中的工作提供有力支持。

二、系统与环境准备

1. 操作系统选择:Spark可在多种操作系统上运行,如Windows、Linux和Mac OS等。建议选用Linux系统,因其稳定性和对大数据处理的优异表现。

2. Java环境:Spark依赖于Java,因此需确保Java环境已安装并配置好。

3. 磁盘空间:考虑到Spark处理大数据的特性,需要预留足够的磁盘空间来存储数据和程序。

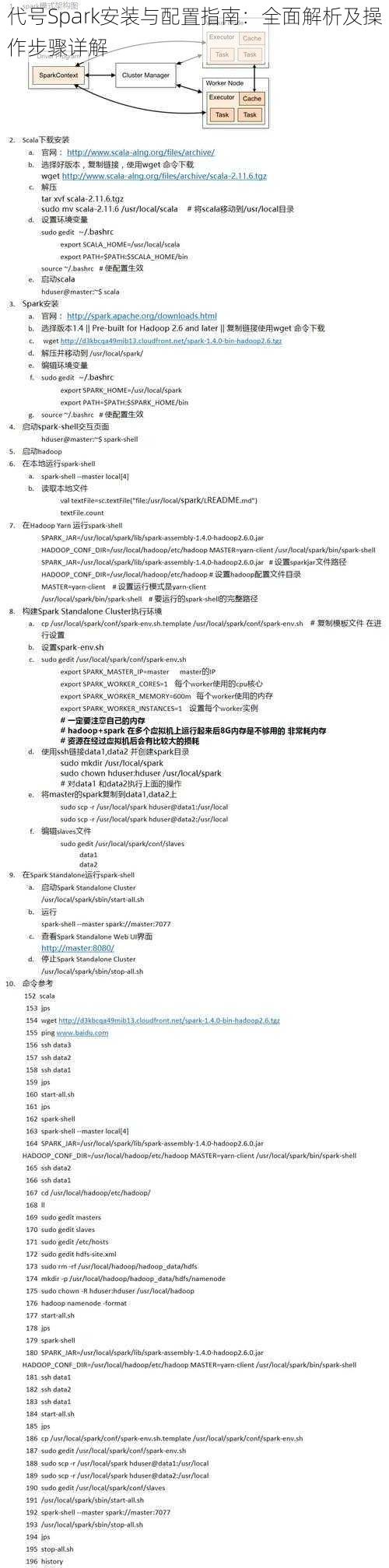

三、下载与安装

1. 访问Apache Spark官网,下载最新稳定版本的Spark。

2. 解压安装包到指定目录,如/opt/spark。

3. 配置环境变量,将Spark的bin目录添加到PATH中,以便全局调用Spark相关命令。

四、配置Spark

1. 配置Master节点:Master节点负责集群的管理和调度,需确保配置正确。

2. 配置Slave节点:Slave节点负责执行任务,可根据实际需求配置多个。

3. 配置环境变量:如配置Spark的内存大小、日志路径等。

4. 配置Hadoop集成(可选):如需使用Hadoop作为存储系统,需进行相应配置。

五、启动与测试

1. 启动Spark:通过spark-master命令启动Master节点,通过spark-slave启动Slave节点。

2. 测试Spark:通过运行简单的Spark程序来测试是否安装成功。

六、常见与解决

1. 网络确保所有节点之间的网络通畅,防火墙设置需允许通信。

2. 内存根据实际需求调整Spark的内存配置,避免内存溢出。

3. 磁盘确保磁盘空间充足,且数据存储路径正确。

七、高级配置

1. 配置Spark UI:启用Spark UI以实时监控集群状态和任务进度。

2. 配置动态资源分配:根据集群负载动态调整资源分配,提高资源利用率。

3. 配置持久化级别:调整数据的持久化级别以提高性能。

本文详细介绍了Spark的安装与配置过程,包括系统与环境准备、下载与安装、配置、启动与测试、常见与解决以及高级配置等方面。希望读者通过本文的学习,能够熟练掌握Spark的安装与配置,为实际应用打下坚实的基础。需要注意的是,在实际应用中,还需根据具体需求进行相应配置和优化,以达到最佳性能。未来研究方向包括进一步优化Spark的性能、扩展其应用领域以及与其他技术的集成等。

本文力求内容丰富、结构清晰、语言准确,希望能为读者提供有价值的参考。如有更多疑问或需求,请查阅官方文档或咨询专业人士。